@pdire sagte: Warum kann man kein Filter-Profil speichern?

In der Praxis ist das Problem eher umgekehrt: Alle neu gesetzten Filter werden immer sofort gespeichert und bleiben aktiv – auch nach Neustart des Programms (ausser die Filter der “Sender” und der Filter “Thema”)…

Ich vermute mal, dass du nicht erfolgreich warst, ein Filter-Profil – wie von dir gewünscht – zu speichern. Der Punkt ist, dass das Vorgehen relativ unintuitiv bzw. ungewöhnlich ist (sollte aber wohl auch unter masOS 12 funktionieren) und ein eigentliches Speichern von User-Seite her nicht aktiv erfolgt. Vorgehen:

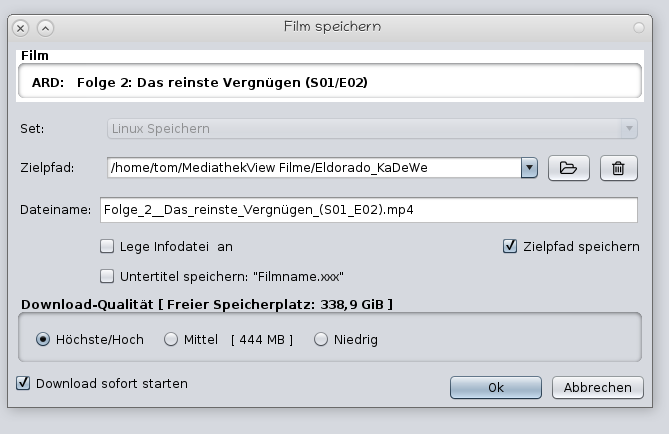

Drücke auf den Plus-Button (vgl. obiger Screenshot) im Filterpanel und gib dem Filterprofil den gewünschten Namen.

Stelle nun alle gewünschten Filter ein. Alles was du jetzt gesetzt hast, bleibt so gespeichert.

Wenn du wieder filterlos oder mit deinen immer gültigen Standardfiltern unterwegs sein willst, dann wechsle ins Filterprofil 1 zurück.

Hinweise:

Man sollte ein Profil haben, wo man temporäre bzw. wechselnde Filter einstellen kann (Filterprofil 1).

Alle weiteren Profile stellt man einmal ein und stellt bei Bedarf auf diese um. Falls dort zusätzliche Filter einstellt werden, werden diese immer sofort gespeichert (das heisst, man muss die Änderungen rückgängig machen, bevor man das Filterprofil wechselt).

Einschränkung: Der für die meisten wohl wichtigste Filter – die Sender – kann man leider (noch) nicht speichern. Es lassen sich auch keine Suchbegriffe (“Thema/Titel”) via Filterprofil speichern…

Da ich immer konkrete Sendungen suche und nicht die Liste als Fernsehprogramm (miss)brauche, benötige ich kaum je Filter aus dem Filterpanel – ausser den in diesem Zusammenhang nutzlosen Senderfilter. In der Praxis verwende ich deshalb persönlich keine Filterprofile mehr (früher konnten die mehr, wenn auch schon damals die Verwendung nicht intuitiv und nicht dokumentiert war).

PS: Und was hat dein Problem überhaupt mit “Systemeinstellungen” (Thread-Überschrift) zu tun?